Čo je crawlovanie vo vyhľadávaní?

Crawlovanie je proces, pri ktorom roboty vyhľadávacích nástrojov (web crawler, pavúky) objavujú, prechádzajú a sťahujú obsah na rôznych URL adresách. Neprechádzajú všetky URL adresy. Niektoré môžete vyňať pomocou informácie v súbore robots.txt.

Crawler o stránke zhromažďuje údaje vrátane textu, obrázkov či videí a snaží sa čo najlepšie pochopiť jej obsah. Získané dáta uloží do indexu – virtuálnej databázy, z ktorej pochádzajú všetky výsledky vyhľadávania.

e-shop

Prečo potrebujete, aby bol web crawlovaný?

Bez crawlovania a následnej indexácie sa web neobjaví vo výsledkoch vyhľadávania. To znamená, že sa nezobrazíte v Googli a potenciálni zákazníci nájdu po zadaní dopytu len konkurenčné stránky.

Problémy s crawlovaním a indexáciou sa nemusia týkať celej stránky. Niekedy chýba dôležitá podstránka alebo Google indexuje nový obsah príliš pomaly.

Pre spravodajské weby je pomalá indexácia rovnako veľký problém ako žiadna. Ak píšete o výsledkoch športových podujatí alebo aktuálnych správach, ktoré sa do indexu dostávajú s časovým oneskorením, máte problém.

e-shop

Ako funguje crawlovanie webových stránok?

Práca crawlerov je presne definovaná a pozostáva z nasledujúcich krokov:

- Objavovanie URL adries: Existuje niekoľko spôsobov, ako sa crawleri dozvedia o nových stránkach. Pomocou sitemáp, cez predtým prehľadávané weby alebo interné a externé odkazy.

- Stiahnutie obsahu: Keď crawler objaví URL adresu, stiahne jej obsah vrátane HTML, obrázkov a iných mediálnych súborov.

- Indexovanie a extrahovanie odkazov: Stiahnutý obsah crawler analyzuje a rozhodne o jeho zaradení, alebo nezaradení do indexu. Zaindexovanej URL adrese pridelí pre konkrétne kľúčové slová pozíciu vo výsledkoch vyhľadávania. Zároveň vytiahne odkazy do ďalšieho plánu crawlovania. Samozrejme len tie, ktoré sú podstatné a zodpovedajú usmerneniam webu.

- Prioritizácia URL adries: Každú URL adresu, ktorú potrebuje crawler opäť navštíviť, zaradí do zoznamu a priradí jej prioritu na základe relevancie a dôležitosti.

Prečo nie sú všetky stránky zaindexované?

Crawlovaním webových stránok vyhľadávač, najčastejšie Google, neprestajne dopĺňa index o nové stránky. Takto neustále aktualizuje dáta o nový obsah.

Google, pochopiteľne, neindexuje všetky stránky. Mnohé ani nepotrebujete, aby zaindexoval (napríklad niektoré podstránky vytvorené filtráciou, vybrané varianty produktov alebo kroky v košíku).

Nedochádza k indexácii

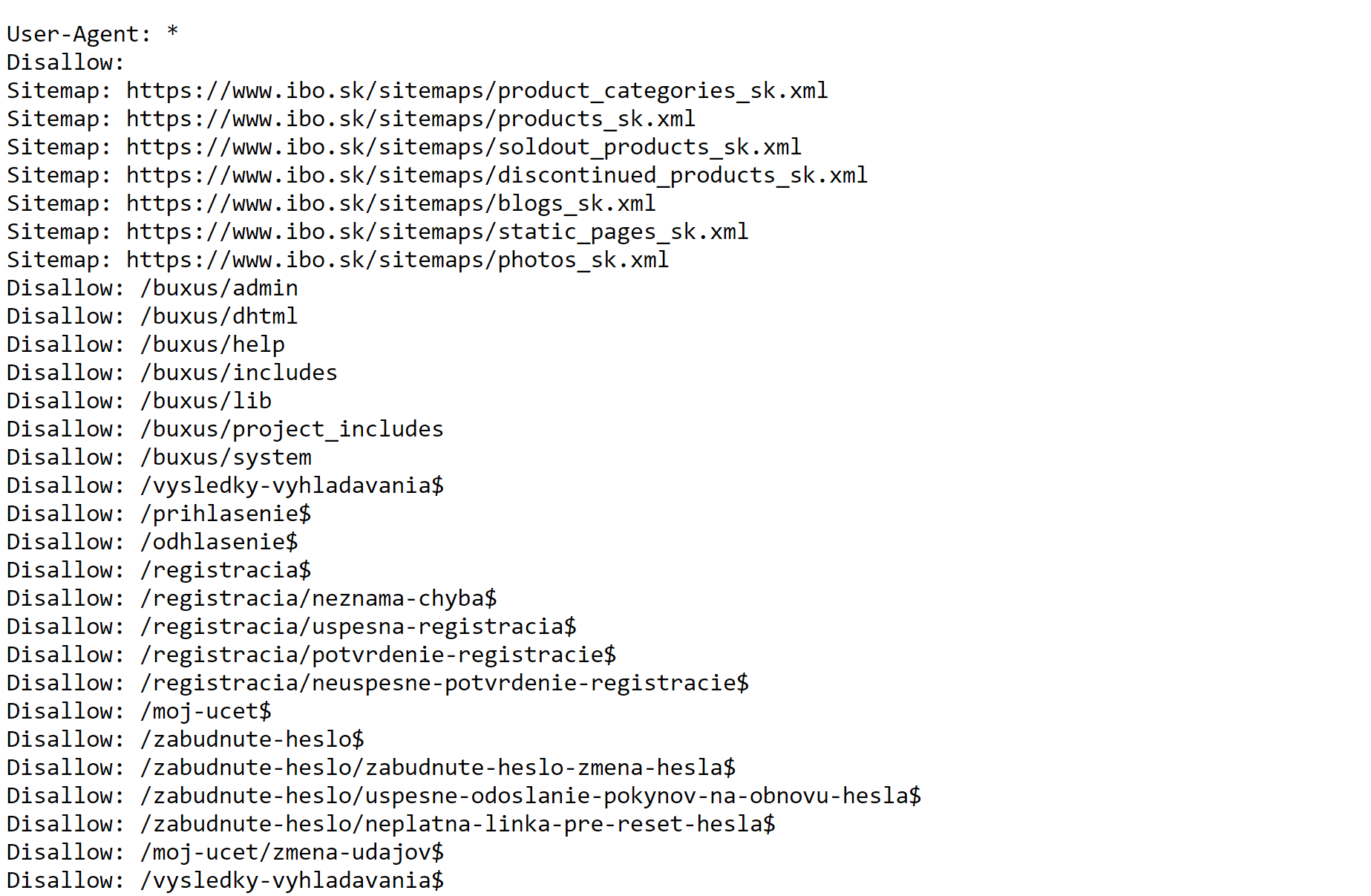

Chýbajúca indexácia stránky často súvisí so zákazom prechádzania danej podstránky uvedenom v súbore robots.txt. Nastavuje sa pomocou príkazu “disallow”. Ak máte v robots.txt podstránky za príkazom disallow, preverte, či naozaj chcete, aby roboty stránky nenavštevovali alebo ide o omyl.

Zaujíma vás, v akom stave je váš web? Vygenerujte si PDF audit webu.

Ako optimalizovať crawlovanie webových stránok?

Na zvýšenie efektivity prechádzania webovej stránky potrebujete jednoduchú štruktúru URL adries, zrozumiteľné sitemapy, sieť interného a externého prelinkovania a niekoľko ďalších nástrojov a taktík. Všetky si postupne prejdeme aj s praktickými ukážkami.

Optimalizujte XML sitemapy

Na organizáciu webu pre botov slúži sitemapa, ktorá má xml formát a odporúčame ju pre každý web, ktorý má viac ako 100 podstránok. V ideálnom prípade ju generujte pomocou pluginov pravidelne a automaticky.

Ako vyzerá a čo obsahuje sitemapa?

Na prvý pohľad vyzerá ako obsah webu, ale pre roboty. Vďaka nej vedia, ktoré stránky webu sú tie najdôležitejšie. V sitemapách by mali byť iba tie stránky, ktoré chcete, aby skončili v indexe.

Sitemapa by mala okrem URL adresy obsahovať aj dátum poslednej modifikácie. Vďaka nemu prichádzajúci robot vie, na ktorých stránkach nastali zmeny od jeho poslednej návštevy.

Pozor na crawl budget a priechodnosť webu

Každý web potrebuje, aby Google roboty pravidelne navštevovali dôležité podstránky a čo najskôr odhalili nové. Robot má však na web vyhradenú len obmedzenú výpočtovú kapacitu. Ako z nej získať čo najviac?

Čo je to crawl budget

Vyhľadávač prideľuje webovým stránkam crawl budget na základe odozvy zo servera, veľkosti webu, frekvencie, ktorou aktualizujete stránky a prelinkovania stránok (interného aj externého). Zjednodušene môžeme povedať, že Google prechádza populárne URL adresy oveľa častejšie.

“Najzásadnejší nástroj pre optimalizáciu crawlovania je rozhodne dobre nakonfigurovaný robots.txt a pravidelne aktualizovaná Sitemapa s dobre nastaveným <lastmod> tagom.

Ako SEO špecialisti však musíme monitorovať a zabezpečiť “zdravie prechádzania”. To znamená eliminovať 5XX stavové kódy, soft 404 či reťazové presmerovanie. Nesmieme zabudnúť ani na každodenný chlebíček SEO špecialistu, duplicitný obsah,” prezrádza náš SEO špecialista Martin Gajdoš.

Odstráňte duplicitné stránky z vyhľadávania

Duplicitný obsah komplikuje indexovanie webu. Duplicita znamená, že existuje viacero URL adries, na ktorých je identický alebo veľmi podobný obsah. Googlebot sa potom nevie rozhodnúť, ktorá stránka je hlavná a môže mylne prideliť nesprávnu hodnotu. Výsledkom sú nižšie pozície vo vyhľadávaní.

V prípade e-shopuE-shop alebo inými slovami internetový obchod je virtuálna platforma, na ktorej nakupujete alebo predávate produkty cez internet. Vďaka neobmedze... More vzniká duplicita najčastejšie filtráciou produktov. Stáva sa to najmä pri cene. Ak návštevník posunie cenu čo i len o jedno euro, pravdepodobne sa zobrazí veľmi podobná stránka s takmer identickým obsahom a duplicita je na svete.

V takom prípade musíte URL adresu odlíšiť pri každej jednej filtrácii, správne nastaviť kanonizáciu alebo zákazať botom prechádzanie týchto stránok v robots.txt.

Príklad z praxe: IBO

Pri partnerovi IBO sme museli vyriešiť predovšetkým problém s technickým SEO. Komplikácie vznikali pri indexácii, keď roboty prechádzali aj stránky bez väčšej hodnoty.

E-shop mal viac ako 3 milióny indexovaných stránok a 6 miliónov neindexovaných, z ktorých väčšinu tvorili duplicity z filtrácie.

Problém sme vyriešili správnym nastavením pravidiel indexácie pre vyhľadávače.

Pri webstránke takýchto rozmerov vždy riešte crawl budget (výpočtovú kapacitu, ktorú vyhľadávač alokuje na spracovanie stránky) a jeho efektívne využitie.

Nakonfigurovali sme súbor robots.txt, ktorý jasne stanovuje pravidlá pre roboty. Vytvorili sme aj samostatné sitemapy pre kategórie produktov, jednotlivé produkty alebo vypredaný sortiment. Vylúčili sme z indexovania všetky podstránky, ktoré vznikajú pri vyhľadávaní na webe, pri registrácii alebo prihlásení sa do účtu.

Robots.txt pre web ibo.sk, kde sme upravili pravidlá indexácie pre Googlebotov s ohľadom na ciele e-shopu.

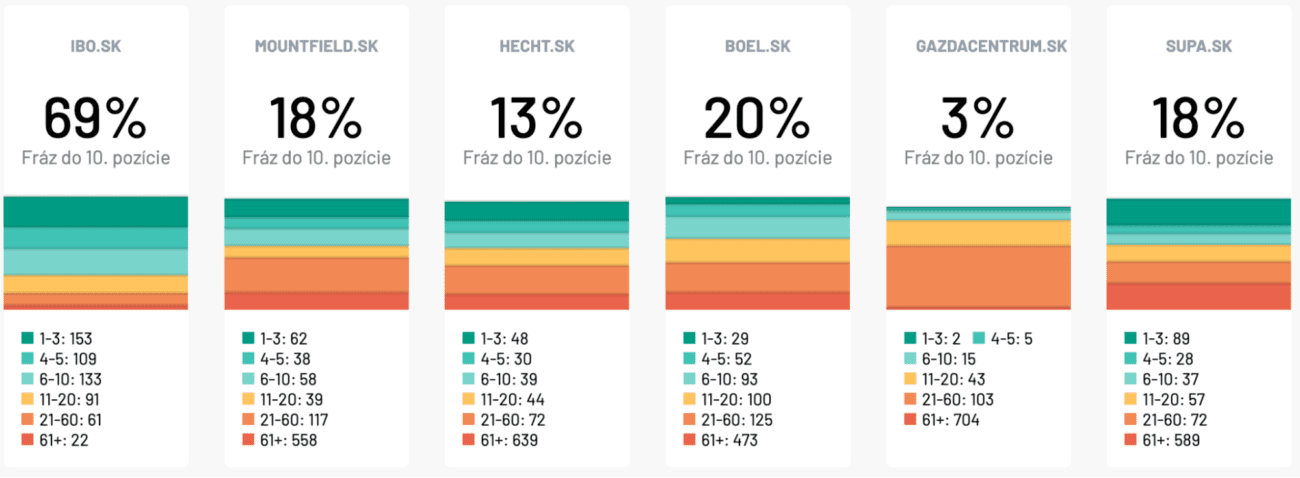

Spolu s úpravou textov v hlavných kategóriách, tvorbou blogu, interným prelinkovaním a kvalitným obsahom sa nám podarilo dostať IBO na priemernú prvú pozíciu na všetky relevantné frázy. Medziročne narástol počet impresií o 133 % a organická návštevnosťČo si predstaviť pod pojmom organická návštevnosť Organická návštevnosť je dôležitým pilierom digitálneho marketingu. Predstavuje ... More o 26 %.

Až 69 % sledovaných kľúčových slov sa zobrazuje na Google do maximálne desiatej pozície. Predstavuje to niekoľkonásobný náskok pred konkurenciou.

Podporte crawlovanie internými odkazmi

Interné odkazy majú veľký vplyv na efektívne crawlovanie. Optimalizujte štruktúru interných odkazov na webovej stránke a zabezpečte jednoduchú navigáciu a prístupnosť relevantných stránok.

Ak strategicky prepojíte rôzne webové stránky, dáte crawlerom jednoznačne najavo, že stránka A súvisí so stránkou B. Zároveň tak vyhľadávač lepšie pochopí obsah webu a vzájomné prepojenie stránok.

Skvelou technikou na budovanie interného prelinkovania sú tematické klastre.

Odstráňte obsah bez hodnoty

Vyčistite webovú stránku od nekvalitného, zastaraného alebo duplicitného obsahu, ktorý odvádza pozornosť crawlerov od nového alebo nedávno aktualizovaného obsahu. Zlúčte podobný obsah a použite presmerovanie 301.

Neindexuje sa váš web správne?

Crawlovanie webových stránok je kľúčovým aspektom SEO a ovplyvňuje indexovanie vášho obsahu vo výsledkoch vyhľadávania. Ak sa váš obsah indexuje neskoro, máte problém s duplicitnými podstránkami alebo crawl budgetom, radi vám pomôžeme.

Náš tím SEO špecialistov má skúsenosti s malými aj veľkými e-shopmi a dokáže zabezpečiť, aby Google našiel a správne zaindexoval všetky najdôležitejšie podstránky.